Дублированный контент часто и долго обсуждался в сфере SEO. На сегодняшний день эта тема все также актуальна. Среди наиболее частых вопросов были и есть:

- как ПС относятся к дублированному контенту?

- как дублированный контент влияет на выдачу?

Слишком беспокоится о дублированном контенте, на сегодняшний день, не стоит, т.к. ПС умело определяют наиболее качественную страницу (оригинал) и выделяют ее среди подобных ей клонов. Тем не менее многих веб-мастеров этот вопрос не оставляет в покое. Один из мучительных вопросов – вопрос бана сайта из-за дублированного контента. Блоги, видео и аудио уроки, SEO статьи и т.д. дают множество советов как избавится от дублированного контента и обеспечить своему сайту долговечное существование.

Одни советуют, что достаточно заблокировать дубликаты, другие – лучше прописать редирект, а третьи говорят, что лучше всего канонизировать страницу. Каждый из предлагаемых методов хорош, и каждый имеет свои недостатки. Обсудим их подробнее. Заранее отмечу, что цель статьи – скорее напомнить о таких способах. Подробный разбор каждого из них – тема отдельных статей с примерами.

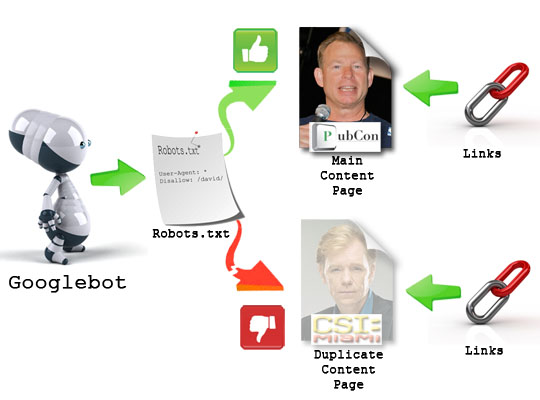

Блокируем в robots.txt

Использование правил в файле robots.txt – наиболее распространенная практика среди веб-мастеров, т.к. правила не требуют особых знаний в синтаксисе. robots.txt популярен не только среди обычных веб-мастеров, но и среди специалистов Google. Вы можете указать файлы и/или каталоги, которые индексировать не надо. Например, это могут быть результаты работы CGI-скиптов, сводка о погоде и пр.

Все прописанные страницы в robots.txt будут исключены из списка посещаемых роботом ПС.

Использование <meta> robots: Noindex/Follow тэги

Другой способ исключить дублированный контент – использовать служебные тэги Noindex/Follow (пример):

<meta name=”robots” content=”noindex,follow” />

Noindex даст команду роботам не индексировать страницу, а Follow разрешит передавать вес внешним ссылкам. Отмечу, что изначально атрибуты Follow и NoFollow создавались для борьбы с SEO спамом, дабы целевые спам страницы не вылазили в выдаче на “незаслуженные” места из-за набранного на шару веса входящих ссылок.

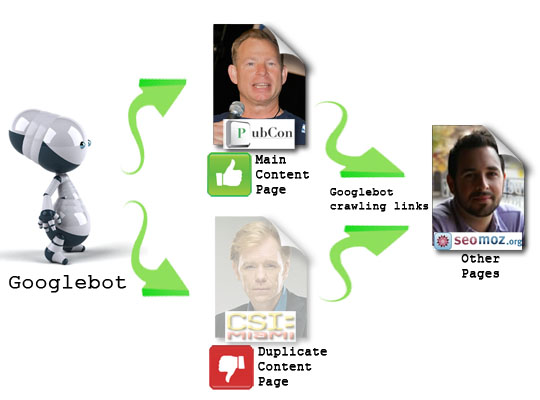

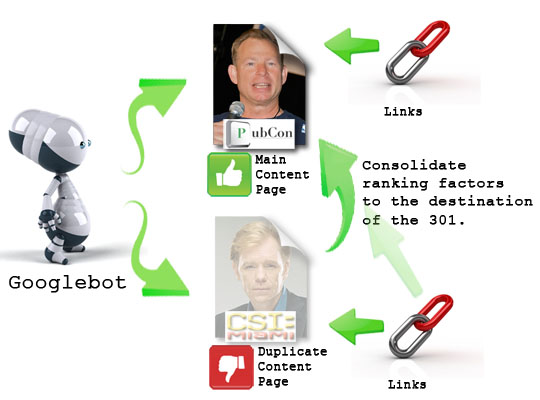

301-й редирект

Что происходит с дублированным контентом при использовании 301-го редиректа? 301-й редирект – отличная вещь в сравнении с первыми двумя. 301-й редирект – это переадресация. Это означает, что страница или целый сайт теперь находится по новому адресу. Робот ПС послушно перейдет на новую страницу. При этом весь вес, ранжирование и т.д. полностью переходят на новый урл. Ничего не теряется и не усекается. Вот почему так популярны склейки доменов. Разные умельцы веб-мастера на этом зарабатывают немало рубликов.

301-й редирект можно осуществить на ПО веб-сервера (Apache, IIS и т.д.) либо посредством программирования на стороне сервера (PHP, ASP/.net, ColdFusion, JSP, Perl и т.д.).

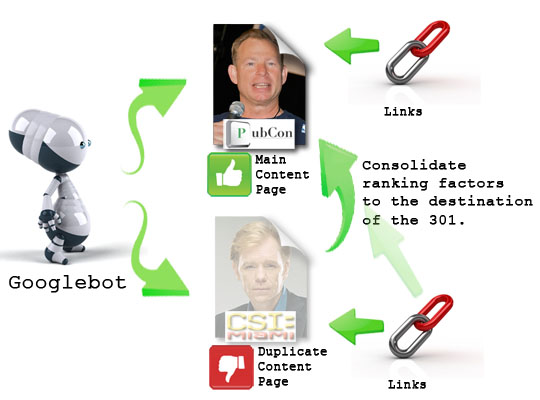

Каноническая ссылка

Каноническая ссылка ведет себя похоже как и 301-й редирект. Страница с дублированным контентом индексироваться не будет (в идеале). В индексе появятся только назначения страницы. Все страницы с указанием канона будут считаться как оригинал.

Простой пример. Допустим, вы посетили интернет магазин и просматриваете страницу о сумках для ноутбуков:

http://www.example.com/travel/luggage/laptop-bags/targus/

В тоже время, другой покупатель ищет в магазине ноутбук. Причем он хочет сэкономить и купить его вместе с сумкой. В интернет-магазинах часто используют такой прием, когда размещают ссылки на сопутствующие или похожие товары. Итак, есть еще один урл:

http://www.example.com/electronics/computers/laptops/accessories/laptop-bags/targus/

Как видите, конечная страница имеет одинаковый контент, хотя на нее есть 2 разные ссылки. В категории laptops есть подкатегория для аксессуаров, в которую входит категория targus (фирма такая есть).

Вторая ссылка создана для удобства навигации, т.к. сумки для ноутов – это также аксессуар. Если использовать 301-й редирект, то покупатель автоматом будет переадресован на первую ссылку, а это совсем другой раздел и покупатель будет введен в заблуждение. Если он захочет поискать сумку другого производителя, то ему снова придется идти в раздел электроники, затем аксессуаров и т.д. Ему это надо? Да и нам тоже. Проще использовать здесь канонический тэг, указывающий на оригинал:

<link rel=”canonical” href=”http://www.example.com/travel/luggage/laptop-bags/targus/” />

Все. ПС роботам теперь ясно, где оригинал, а где дубликат. Все довольны.

Альтернативная ссылка

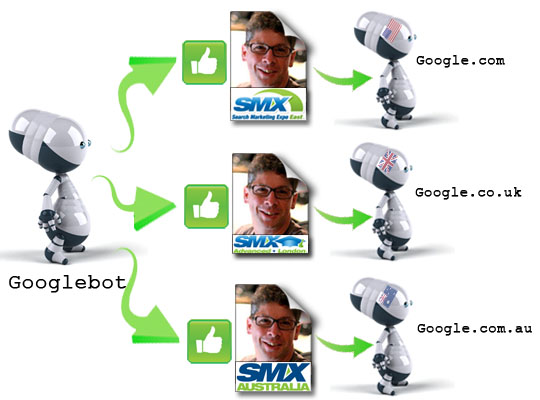

Тэг альтернативной ссылки похож на тэг канонической. В основном он используется в международных или многоязычных SEO целях.

<link rel=”alternate” hreflang=”en” href=”http://www.example.com/path” />

<link rel=”alternate” hreflang=”en” href=”http://www.example.co.uk/path” />

<link rel=”alternate” hreflang=”en” href=”http://www.example.com.au/path” />

Канонический тэг полностью исключает все дубликаты из индекса, в то время как альтернативный тэг сохраняет их в индексе. Это 1) помогает ПС (Google) выбрать подходящую страницу в зависимости от региона или языка и 2) устраняет проблему с дублированным контентом.

проводил маленький эксперимент, на одном сайте была обыкновенная ссылка на новый урл, на другом 301 , выигрывает пока первое))

интересное замечание, а в яндексе этот же алгоритм определения?

надо просто не делать дублированного контента, и всё

Интересная тема. Написано все очень доходчиво. Я сам давно использую robots.txt

Наверное надо заняться этим. Но, думаю поисковики сами знают об особенностях современных CMS и сами прекрасно справляются с дублями.

А зачем делать 2 одинаковые стр?

Спасибо за помощь. Статья помогла с настройками видимо сайта в яндексе.

Да думаю в Яндексе такой же

Антон Козлов, ПС знают. И они не обязаны за веб-мастеров оптимизацию делать.

Etoile, для удобства и юзабилити. Нередко один товар можно отнести к разным группам товаров. В примере, первый урл – это раздел сумок для путешествий (с камерами, ноутами и т.д.),а второй раздел – это конкретно аксессуары для ноутов. Если я ищу сумку под ноут для поездки, то мне лучше первый урл. И таких сотни. Вот для них создают отдельные ветки рубрик. К тому же, это дает плюс к сбору статистики. Сразу видно целевых покупателей: туристы, для дома, бизнес и т.д. … Это правильный подход.

Правда, интересная тема. Я на своем блоге не блокирую и не удаляю дублированный контент, но всякий раз задумываюсь, как это влияет на поиск.

А я боялся у себя дублирования, думал это негативно скажется. Убедили – буду экспериментировать:)

Спасибо, очень познавательно. Вот только в конце поста – это не ошибка, а именно 3 атрибута hreflang с одинаковым значением en?

Читал на том же Seomoz где они предостерегают веб мастеров использовать robots.txt

и приводят примеры где этот самый робот фальшивит.

сейчас что либо изменилось ?

З.Ы

кто с сейпом разбирается, помогите с проблемой. разместил свой сайт wowlib.ru в индексе 12 0000 яндекса, тиц 10. в сейп попало лишь 370 страниц 3 уровня и 1 страница 2 уровня. у меня стоит редирект с wowlib.ru на wowlib.ru/вот типа так

как мне сейчас сделать в этом бардаке все страницы 2 уровня и поднять цены на ссылки, можно мыло, ася 2104163

Интересно, если воспользоваться редиректом 301, каким образом суммируется PR? К примеру, я делаю редирект состраницы с PR4 на страницу с PR2. Интересно было бы знать, какой PR можно ожидать от склейки.