Еще один перевод статьи с BlueHatSeo. Думал, что этим постом будет четвертая часть SEO-империи, которую Эли проанонсировал в феврале, но на блоге ее пока нет. Так что давайте поговорим об индексировании сайтов. Я думаю, вам понравится 😉

(Перевод от первого лица.)

После того, как вы создадите сайт-хамелеон или отбеливатель ссылок, вам наверняка придется решить проблему его индексирования в поисковых системах. Возможно, вам еще не приходилось работать с большими сайтами, в которых больше 20k страниц, но, поверьте мне, проиндексировать их не так уж и сложно. Единственное, что я должен отметить, некоторые из приведенных ниже методов лучше всего подходят для сайтов с числом страниц от 20 до 200 тыс. страниц. Для сайтов, у которых больше или меньше страниц, нужно использовать немного иные методы.

Посещение сайта поисковыми ботами

Здесь нужно отметить два важных аспекта. Первый это структура сайта.

Вы должны так организовать сайт, чтобы максимально облегчить ботам работу по его индексированию. Для этого вы должны создать так называемые “узловые” страницы. Узловые страницы — это страницы со ссылками на внутренние страницы. Например, для сайта каталогов узловой страницей можно считать страницу, внизу которой стоит блок ссылок: “Pages 1, 2, 3, 4, …“. Единственная цель и ценность узловой страницы в том, что она помогает проиндексировать другие страницы сайта. Если вам нужно проиндексировать большой сайт, сначала проиндексируйте узловые страницы, и остальные страницы последуют за ними.

Второй важный фактор — количество посещений сайта поисковыми ботами.

Чем больше объем ботового трафика, тем быстрее проиндексируются страницы сайта. Хотя сам объем не играет большого значения: какой толк от того, что боты будут бомбардировать главную страницу сайта и не будут заходить на внутренние? Вы должны направить ботов, куда вам нужно, и здесь очень важна структура, о которой я рассказал выше.

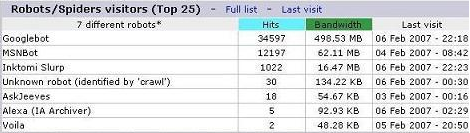

Это скриншот со статистикой одного из моих сайтов-хамелеонов, которому всего 10 дней от роду. Обратных ссылок на него совсем немного, однако это не помешало ботам за 6 дней проиндексировать 10k+ страниц.

Как я уже говорил, сделать это совсем не сложно. Для начала мы займемся базовыми вещами, затем перейдем к более продвинутым приемам и закончим тем, что я называю “сайтами-индексаторами”. Что из всего этого использовать, решать вам. Если вы не готовы применять тот или иной прием или у вас пока нет для этого достаточных знаний, остановитесь на более простых вариантах.

Внутренние ссылки на целевых страницах

Это самое простое, что можно придумать. Давайте вернемся к нашему сайту-хамелеону с партнерскими ссылками на сайта знакомств. Там каждая целевая страница представляет какой-то город. И на каждой странице есть (или можно поставить) ссылки на близлежащие города. (Для этого можно использовать выборку по ZIP-кодам или же вытягивать из базы записи, расположенные до и после ряда, которому соответствует указанный город.) Это позволит поисковым ботам переходить с одной целевой страницы на другую до тех пор, пока не проиндексируют все страницы сайта.

Обратная и/или вращающаяся карта сайта

Наверняка вы уже прикрутили простенькую карту сайта к своему сайту, и теперь она ссылается на все страницы ресурса. Говорят, поисковые боты относятся к картам сайта иначе, чем к другим страницам в плане количества ссылок, по которым они готовы перейти, но когда у вас есть 20k страниц и все их нужно проиндексировать, стандартная карта может оказаться малоэффективной.

Если мы отталкиваемся от того факта, что бот переходит только по определенному количеству ссылок с карты сайта, значит, нам нужно сделать так, чтобы он каким-то образом охватил все ссылки. Если у вас небольшой ресурс на 5k страниц, вам вряд ли придется об этом беспокоиться, но если у вас сайт-хамелеон на 30k+ адресов, стандартная карта сайта может оказаться бесполезной тратой времени. Дело в том, что ссылки с главной страницы ведут на внутренние страницы с низким порядковым номером в базе данных. Точно так же устроена и карта сайта — сначала она выдает первые ряды в базе, затем последние. В такой ситуации боты будут ходить по одним и тем же страницам.

Чтобы решить проблему, разверните карту сайта на 180 градусов. Для этого в базе данных замените ORDER BY ‘id’ на ORDER BY ‘id’ DESC (атрибут DESC подразумевает то, что последние страницы будут отображаться первыми, а первые — последними). Так страницы, которые, как правило, плетутся в хвосте карты, сразу привлекут на себя внимание ботов, и те их быстренько проиндексируют. Если с внутренней перелинковкой проблем нет, боты будут индексировать страницы с обеих сторон базы данных и со временем сойдутся в центре. В таком случае полная индексация сайта произойдет намного быстрее, чем если бы боты постепенно шли с первых страниц и до последних.

Еще лучше сделать вращающуюся карту сайта. Допустим, у вас есть 30k страниц. В течение первой недели расположение страниц на карте должно выглядеть так: 30,000-1. Затем вы берете первые 5k страниц и переносите их в конец карты. Теперь карта выглядит так: 25,000-1:30,000-25,001. В начале третьей недели вы снова прокручиваете карту и теперь она имеет вид: 20,000-1:30,30,000-20,001. И так до конца. Этот метод весьма эффективен.

Ссылки на внутренние страницы с других сайтов

Этот метод тоже позволяет существенно увеличить объем ботового трафика на внутренних страницах сайта. Благодаря ему вы сможете ткнуть ботов носом в те участки, которые они упорно не хотят индексировать. Чтобы операция прошла успешно, ставьте ссылки на узловые страницы. Ссылки могут быть идти как с ваших собственных, так и со сторонних ресурсов.

Сайты-индексаторы

Это самая эффективная тактика индексирования из всех, что я описал в этом посте. Сайт-индексатор — это специальный сайт, который вытягивает контент с других ваших сайтов, индексирует свои внутренние страницы и затем самообновляется — закрывает проиндексированные страницы и подхватывает другие, непроиндексированные. Создание такого сайта не займет много времени, однако для этого нужно разбираться в коде.

Сначала вам нужно создать главную страницу, которая будет ссылаться на 50-100 внутренних страниц. Каждая внутренняя страница будет наполняться контентом тех страниц из базы крупного сайта (например, сайта-хамелеона), которые вам нужно проиндексировать. Чтобы главную страницу сайта-индексатора не покидали поисковые боты, направьте на нее поток ссылочного веса с сайтов-отбеливателей ссылок.

После этого задайте команду cron, чтобы он ежедневно вытягивал из Google, Yahoo и MSN данные по запросу SITE:вашдомен.com. Создайте скрипт, который будет парсить результаты и сравнивать их со списком страниц на сайте-индексаторе. Как только страница будет проиндексирована во всех трех поисковиках, скрипт должен ставить на нее 301-й редирект, который будет вести на ее близнеца (целевую страницу с крупного сайта), и отмечать ее в базе данных как проиндексированную.

Теперь сайт-индексатор не будет обращать на нее внимание, и для создания новых внутренних станиц будет подхватывать только те страницы, которые еще не были проиндексированы каким-то (или всеми) из поисковиков. Такой сайт работает на автомате и в этом его настоящая ценность.

Сайт-индексатор будет трудиться до тех пор, пока все страницы крупного сайта не будут проиндексированы в основных поисковых системах. Этот метод работает настолько эффективно, что даже при полном отсутствии внешних ссылок на крупный сайт вы все равно сможете проиндексировать его внутренние страницы. Для этого вам понадобится всего несколько сайтов-индексаторов.

Записи по теме:

- Изучение обратных ссылок конкурентов

- Как создать серый сайт

- Захват ниши и топа поисковой выдачи

- Создание SEO-империи — Продолжение

Спасибо за статью! Хотя я еще не все понимаю, местами читается с трудом )) – я новичок в этом деле. Надо еще учиться, учиться и учиться… Но тем не менее, кое-какие интересные вещи взял на заметку.

Очень в тему оказалось. У меня тут как раз проблема. Есть форум (древовидный – т.е. считай каждый пост это страница вида ru/message.php?id=XXXX, разделов нет – все одной лентой) – яндекс уже поряда 180к страниц проиндексировал. Гул в текущий момент всего 2к. В лучшие времена было 10к.

Что можно сделать?

Все это конечно хорошо, но фильтры не дремлют. 🙂

У меня Google за пару месяцев слопал около 35000 страниц, а вот Яндекс всего-то 2000…

а sitemap от гугля разве не помогает?

Яндекс тупой, как дрова

По моему это прямой путь к банну в Google.

В контексте данной статьи по моему проще будет на сильных форумах разместить в подписи ссылку. С главным условием, что там не запрещена индексация ссылок в подписи.

Двое суток и почти все страницы сайта если их не более нескольких тысяч будут в индексе.

Я добавил себе ссылки на узловые страницы с главной, так поисковики (гугл и яндекс, яху) прям ашалели – по 1500-2500 страниц за день индексируют. До этого яндекс слабо индексировал, а щас вроде зашевелился.

Поисковики ж любят по ссылкам шариться 🙂

У меня есть сайт http://uralrepetitor.ru на около 100 000 страниц, и бот гугла смог проиндексировать всего 3000 страниц, а яндекс всего 1500 как мне засунуть в индекс все страницы?

Эдуард, сделайте ссылки с морды на “узловые страницы”, если есть. Больше ссылок с морды вглубь сайта. Также скормите гуглу и яндексу сайтмап сайта. И будет вам счастье.

Я у себя на сепарсере повесил ссылки на узловые страницы, так после этого гугл и яндекс по несколько тыщ. в день индексируют.

сегодня яндекс уже обошел 9993 страниц, гугл – 864, Yahoo – 2061. Вчера Yandex – 5321, Google – 2541, Yahoo – 2888.

Спасибо попробую дать задание програмисту.

http://www.consultinga.net/

У моего сайта 38 000 (новый каталог) + 83 000 (старый каталог)страниц, проиндексированно было 6 000 страниц старого каталога, после генерации (своим скриптом) карты сайта и автоматического (скриптом) написания тайтлов и тегов – началась активная индексация гуглом.

Добавил на сайт гугл кастом серч.

за 10 дней дошли до 40000 страниц проиндексированных страниц.

Тк большое колличество страниц старого каталога мне в выдаче не нужно, я снял внутреннюю перелинковку старго каталога (покупатели терялись)и перенаправил все ссылки на новый.

После чего старый каталог начал выпадать из выдачи (-1000 страниц в день).

Итак рецепт: Уникальные тайтлы, уникальные кеи + внутренняя перелинковка

сорри + sitemap.xml , ну если гугл сайт серч добавите – то за 500 баков он 50 000 штук страниц заиндексит без проблем + индексация по указанию. прикол в том что если гугле сайт нравится (контент уникален + подписаны альты и кеи и все это соответствует) – то он сам все сожрет, “меры” принимать надо когда хочеш чтолибо сделать быстро, или контент не очень отличается. Если контент одинаковый – страницы после индексации начнут склеиваться.

добротная статья, у меня на одном сайте с покупным в ксапе контентом уже почти 2 месяца как не может проиндексироватся хоть одна страничка яндексом…

Методы понятны. Есть еще такой способ: сделать так чтобы в рсс – ссылка краткой новости вела на полную. можно множество комбинаций прдумать

В нынешних условиях все процедуры связанные с ускоренным предложением поискавикам большого количества новых ссылок караются баном, ну или, откатом на другие позиции.

Надеюсь что в скором будущем, когда буду делать сайт более 20 тыс. страниц, эта статья мне поможет. Заранее огромное спасибо автору!

большой человеческий респект автору за статью!